Implementare un sistema per la gestione di qualità dei dati può essere un'operazione lunga e articolata. Tuttavia consente di mappare e documentare le attività organizzative e operative, valutandone la sostenibilità. Inoltre, permette di analizzare il contesto, i rischi e le opportunità, evidenziando le criticità che possono emergere nelle varie fasi del ciclo di vita dei dati. Nell’articolo il Centro Nazionale Dati Oceanografici (OGS-NODC) spiega come ha implementato un sistema di gestione per la qualità e i vantaggi che ha ottenuto nello svolgimento delle attività previste dal suo mandato

I dati scientifici sono un bene comune che va salvaguardato e condiviso. Dati e informazioni di ricerca accessibili e affidabili consentono di effettuare valutazioni e prendere decisioni, anche politiche, basate sull’evidenza scientifica. Gli istituti di ricerca hanno la responsabilità di garantire la qualità dei servizi sviluppati per la validazione, conservazione e distribuzione dei dati. A tal scopo, una delle soluzioni possibili è implementare un sistema di gestione per il miglioramento continuo della qualità dei servizi, basato su standard internazionali. Ciò tuttavia richiede un’attenta valutazione delle risorse economiche, umane e infrastrutturali necessarie per la messa a punto e il mantenimento del Sistema di Gestione per la Qualità (SGQ). In questo articolo si descrive l’esperienza maturata in tale ambito dal Centro Nazionale Dati Oceanografici (OGS-NODC) gestito dall’Istituto Nazionale di Oceanografia e di Geofisica Sperimentale - OGS.

OGS-NODC è il riferimento italiano nel Sistema Internazionale di Scambio di Dati e Informazioni Oceanografici della Commissione Oceanografica Intergovernativa dell’UNESCO. Il Centro si occupa della gestione e libera ridistribuzione di dati marini, provenienti prevalentemente dalla comunità scientifica nazionale e internazionale, ma anche dal settore civile e imprenditoriale. L’archivio dati gestito dall’ OGS-NODC preserva oltre 460 milioni di misurazioni raccolte dalla fine del 1800 a oggi nel Mediterraneo e nei mari limitrofi. Di queste il 75,8% è liberamente accessibile a tutti gli utenti e il 24,2% previa autorizzazione di chi ha fornito i dati.

Nel 2022 il Centro ha deciso di intraprendere un percorso per il continuo miglioramento dei propri servizi in maniera strutturata e documentata. Questo è stato possibile attraverso l’implementazione di un SGQ.

Il SGQ è stato sviluppato dal Centro anche al fine di ottenere un riconoscimento ufficiale del suo ruolo nazionale nella gestione dei dati marini. Tale obiettivo è stato raggiunto nel 2024, quando il Centro è stato accreditato dall’UNESCO come Centro Nazionale Dati Oceanografici del programma internazionale di scambio di dati e informazioni oceanografici (IODE). La rete IODE è composta da 101 centri dati in 68 stati membri tra cui Africa, America Latina e della regione del Pacifico occidentale. L’OGS-NODC è stato accreditato per aver implementato un SGQ e per agire in conformità con gli standard internazionali relativi alla gestione dei dati marini e alla scienza aperta. Lavora per la qualità nella gestione dei dati, verificando la loro validità, garantendone la conservazione, la sicurezza e l’accessibilità. Come richiesto dall’UNESCO, il SGQ del Centro si basa su quanto prescritto dalla norma UNI EN ISO 9001:2015 “Sistema di Gestione per la Qualità - Requisiti”.

Di seguito sono sintetizzate le tappe più importanti del percorso che ha portato allo sviluppo del SGQ dell’OGS-NODC e le fasi principali per il suo mantenimento. Infine, vengono forniti alcuni esempi di strumenti del SGQ implementati dal Centro.

Per dare il via al SGQ è stato fondamentale il sostegno dei vertici dell'organizzazione; in particolare, l’impegno della direzione di OGS-NODC nello stabilire una politica e obiettivi di qualità chiari e condivisi e nel fornire il supporto necessario, in termini di risorse economiche, umane e infrastrutturali, per garantire l’implementazione del SGQ.

Il passo successivo è stato la comprensione del contesto interno ed esterno: nel primo caso si intendono i punti di forza e di debolezza propri del Centro al momento dell’analisi, mentre nel secondo caso ci si riferisce ai fattori politici, economici, sociali, ambientali e legali che sono al di là della sfera d’influenza del Centro, ma ai quali è necessario reagire con strategie ad hoc.

Sono stati implementati dei sistemi per soddisfare due importanti requisiti della ISO 9001, ossia, la valutazione della soddisfazione degli utenti e la mitigazione dei rischi. Inoltre, seguendo il recente approccio per processi della norma, le attività del Centro sono state documentate attraverso diagrammi di flusso, che spiegano cosa viene fatto, e procedure che descrivono come viene fatto.

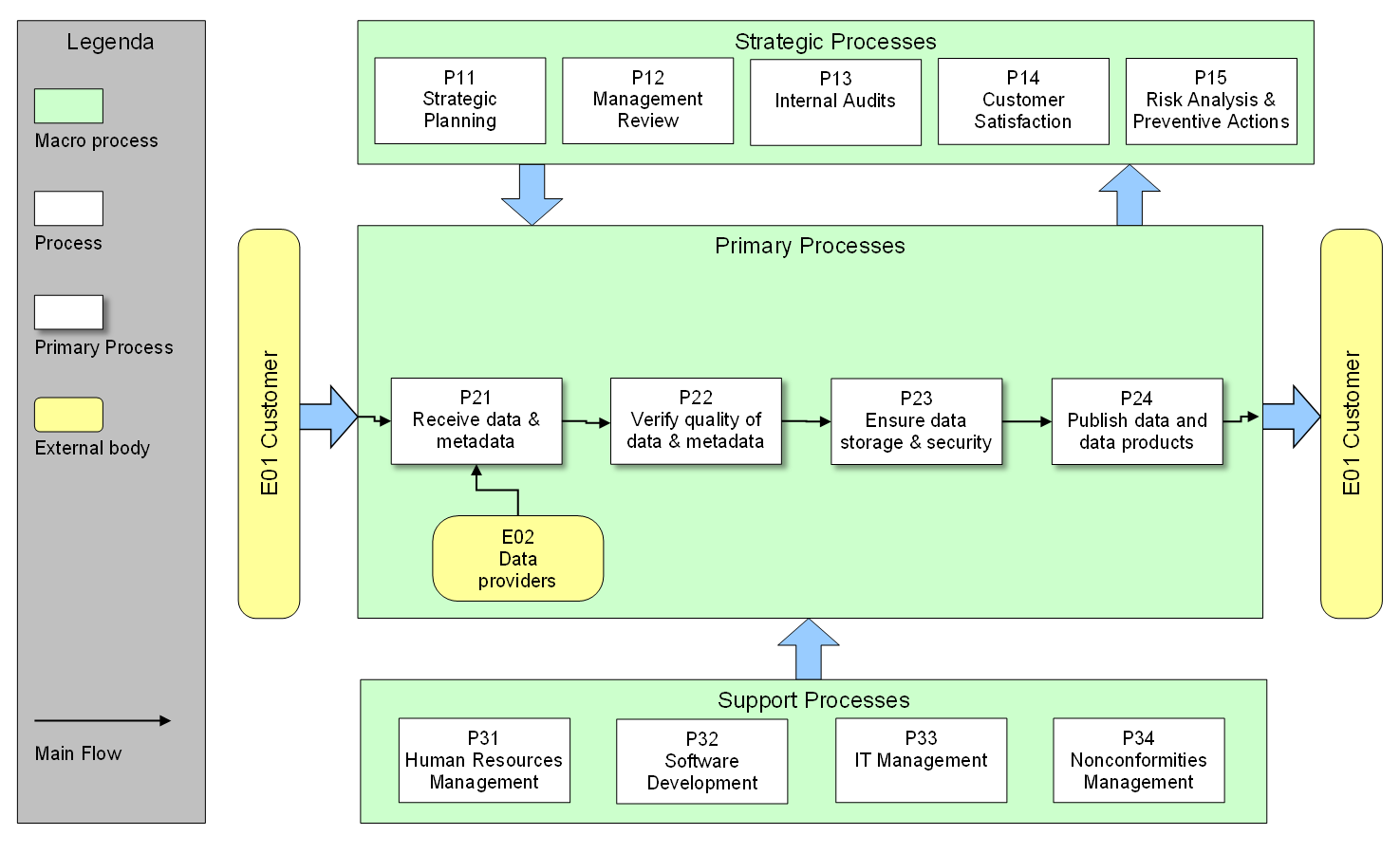

In particolare, è stata definita una struttura di processi multilivello, raggruppati in tre tipologie principali: Strategici, Primari e di Supporto (Figura 1).

Figura 1 Mappa di primo livello dei processi Strategici, Primari e di Supporto.

I processi strategici e le relative procedure descrivono e supportano la pianificazione strategica a medio e lungo termine. Nei processi strategici sono inclusi i metodi e gli strumenti utilizzati per 1) valutare la soddisfazione dei clienti e 2) prevenire e mitigare i rischi. In questa tipologia di processi rientrano anche gli audit interni svolti da personale, interno o esterno al Centro, non coinvolto nelle attività oggetto dell’audit.

I processi primari coprono tutte le attività operative strettamente legate alla gestione dei dati. In particolare, è stato definito un processo per descrivere le diverse fonti di dati e i tipi di dati ricevuti dall’OGS-NODC in tempo quasi reale (NRT) o ritardato (DM), un altro per descrivere il ciclo di vita completo del processamento dei dati, facendo riferimento alle azioni intraprese dalla ricezione dei dati alla loro pubblicazione. Questo processo è suddiviso in 4 livelli che descrivono le attività dell'OGS-NODC quando a) vengono ricevuti i dati; b) viene verificata la loro qualità; c) si garantisce l'archiviazione e la sicurezza dei dati; d) vengono resi disponibili, tramite specifici servizi web, i dati/metadati e i prodotti relativi ai dati.

I processi di supporto servono per gestire le risorse umane del Centro, le non conformità e le attività legate allo sviluppo dei software necessari per il funzionamento del Centro e dei suoi servizi. Grazie al SGQ è stato possibile definire meglio le figure professionali necessarie per il funzionamento del Centro e le relative competenze a livello macroscopico, rispetto a quelle disponibili al momento dell’analisi. A partire da questa analisi è stata realizzata una matrice di competenze, che è uno degli strumenti per monitorare l’andamento delle risorse umane, identificare eventuali carenze e, ove necessario, mettere a punto un piano di formazione e/o di reclutamento di nuovo personale.

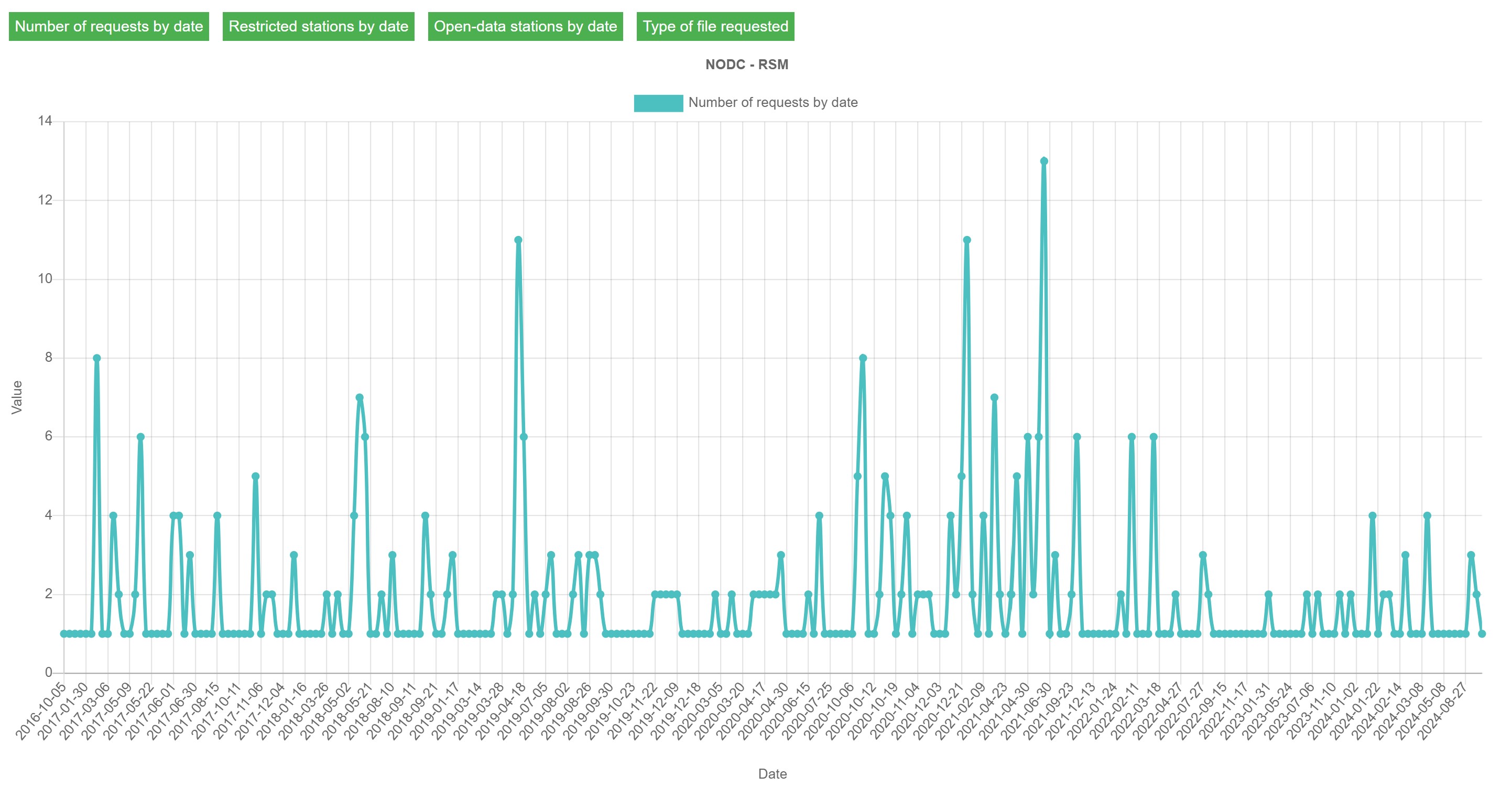

Il sistema di monitoraggio delle prestazioni delle attività cardine del Centro si basa sulla misurazione di indicatori quantitativi. Nello specifico sono stati definiti 10 indicatori e implementati i relativi strumenti di monitoraggio. Gli indicatori monitorano diversi aspetti dell’operatività del Centro. Tra questi vi sono, ad esempio, il tempo medio di inserimento dei dati nel database o il numero di non conformità relative al controllo di qualità dei dati. In alcuni casi, come quello delle non conformità, il registro è anche lo strumento per gestire lo stato di avanzamento delle attività volte alla risoluzione del problema. Indicatori diversi implicano strumenti di monitoraggio diversi, tra cui il questionario per valutare la soddisfazione dei clienti rispetto ai servizi di accesso ai dati, oppure i sistemi, manuali o automatizzati (Figura 2), per conteggiare il numero di dati inviati o richiesti al Centro e misurare le sue prestazioni rispetto ai target stabiliti.

Figura 2 Strumento di monitoraggio utilizzato per ottenere la metrica “Numero di richieste di dati all’anno” tramite il servizio di accesso ai dati dell’ OGS-NODC.

Una volta definiti e popolati tutti gli strumenti di analisi sopra descritti, la gestione del SGQ si svolge ripetendo ciclicamente quattro azioni: pianificare, agire, controllare e consolidare il miglioramento. Questa tecnica, prevista dalla ISO 9001, prende il nome di ciclo di Deming. Ogni ciclo si chiude con un riesame di direzione annuale di tutti i processi, che permette di definire un nuovo piano di azioni partendo da quello dell’anno precedente.

Arrivato a questo punto dell’articolo, chiunque lo stia leggendo si sarà reso conto che implementare un SGQ è un’impresa piuttosto lunga e impegnativa. Quanto lunga e impegnativa? Come al solito, la risposta dipende dalle risorse dedicate allo scopo. A tal proposito si consiglia caldamente di coinvolgere un consulente che aiuti a definire l’architettura del SGQ, sin dalle prime fasi dell’implementazione, e di definire un responsabile interno del SGQ. Queste due figure, supportate dalla direzione e da tutto il personale, sono fondamentali per interpretare i requisiti della norma e contestualizzarli.

Più di qualche lettore si starà anche chiedendo se vale la pena implementare un SGQ. Per prima cosa è bene sapere che in molti, alle prese con un SGQ, si pongono la stessa domanda. Nonostante questo, la risposta è senz’altro positiva.

Il SGQ supporta le attività di gestione dei dati di un'organizzazione in quanto permette la mappatura dei processi organizzativi e operativi, valutandone la sostenibilità. Permette inoltre di analizzare il contesto, i rischi e le opportunità. In pratica, implementare un SGQ significa posizionare una lente di ingrandimento sulle criticità riscontrate nella gestione dei dati.

Conclusioni

Un approccio strutturato del lavoro, finalizzato al raggiungimento di obiettivi di qualità specifici, misurabili, attuabili, rilevanti e pianificati, consente una gestione documentata della complessità delle attività svolte. Questo porta al duplice vantaggio di 1) conseguire una maggiore consapevolezza di tutti i processi operativi, e non solo, 2) facilitare il trasferimento di competenze tra i collaboratori. Ad oggi OGS-NODC, beneficiando della documentazione e del modus operandi del SGQ, sta lavorando allo sviluppo di nuovi sistemi di archiviazione, distribuzione e presentazione dei dati, e alla pianificazione delle strategie di miglioramento a lungo termine.

18 December 2024