Da tempo si discute di come superare i forti limiti e l'anacronismo delle attuali modalità di valutazione della ricerca. Ma se finora le iniziative per trovare strade alternative sono state frammentarie. Ora la Commissione europea ha avviato un processo partecipativo e organico, che prevede una serie di tappe imminenti

“Open Science? Sarebbe bello, ma poi veniamo valutati su riviste e Impact Factor”. Quante volte, dopo un corso o una presentazione, abbiamo sentito questa (legittima) obiezione? Ebbene, sembra proprio giunto il momento in cui la tanto sospirata modifica dei criteri di valutazione della ricerca stia diventando realtà.

La Commissione europea ha infatti lanciato, lo scorso 8 dicembre 2021, l’iniziativa Towards an agreement on reforming research assessment, il cui iter prevede tempi strettissimi: stesura dell’accordo entro il primo semestre 2022, firma nell’autunno, con avvio immediato di una roadmap per il cambiamento (da presentare alla Commissione entro 1 anno dalla firma) e risultati da presentare entro 5 anni. La notizia confortante è che sia il Ministero per la Ricerca sia ANVUR figurano fra i firmatari dell’Espressione di interesse - il che lascia ben sperare in una futura adozione del testo dell’accordo. Per inciso l'Espressione di interesse, già firmata da oltre 300 enti, è ancora aperta.

Ma andiamo con ordine. Che la valutazione della ricerca sia cruciale è evidente da anni: già nel 2016 la Amsterdam call for action on Open Science poneva la riforma dei criteri di valutazione al primo posto fra le 12 azioni raccomandate per aprire la strada alla Open Science, e la Commissione aveva già pubblicato nel 2017 il report Evaluation of research careers fully ackowledging Open Science practices la cui chiave di lettura era “matrix, not metrics”, chiaro invito a considerare diversi aspetti della pratica di ricerca (non solo le pubblicazioni) con pesi diversi a seconda dello stadio di carriera. La modifica dei criteri di valutazione rientra anche fra gli 8 pilastri individuati nel Rapporto finale della Open Science Policy Platform: è evidente che il paradigma della scienza aperta, fondato sulla massima condivisione e collaborazione, non possa utilizzare come indicatori elementi basati su una competizione sfrenata quali l’Impact Factor.

Come riconosceva già nel 2014 lo International science council, i criteri attuali non solo considerano unicamente il risultato finale (l’articolo) impedendo di riconoscere e premiare la condivisione di tutti gli altri elementi del processo di ricerca (dati, metodi, software, protocolli…), ma producono comportamenti adattivi da parte dei ricercatori e contribuiscono a tenere in piedi il sistema disfunzionale delle riviste, che genera profitti enormi per gli editori commerciali - pagati con fondi pubblici:

These metrics in turn affect the behaviour of researchers, such as their choice of journals, as they seek to maximize their performance as measured by the metrics used. They can contribute to the maintenance of high journal prices, promote intense competition rather than openness and sharing, and fail to recognise research contributions such as the production of datasets, software, code, blogs, wikis and forums.

Finora, però, le numerose iniziative volte a scardinare questo sistema che ha creato dannosi effetti collaterali (basta leggere Impact or perish. L’ossessione per l’impatto delle pubblicazioni scientifiche genera frodi e condotte abusive di Mario Biagioli) erano legate a singoli enti di ricerca o a iniziative nazionali quali la decisione delle università olandesi nel 2021 di abbandonare l’Impact Factor nelle procedure di valutazione. Molti di questi enti (incluso ERC, European Research Council) hanno firmato la San Francisco Declaration on Research Assessment (DORA Declaration), impegnandosi a non utilizzare più la logica dei ranking di riviste (non solo l’Impact Factor) nella valutazione interna. Scorrendo le pagine di DORA si ha un’idea del fermento in atto fuori d’Italia su questi temi, con numerosi esempi e casi di studio di possibili soluzioni alternative - fra cui quella olandese di Room for everyone’s talent che considera non solo la produzione scientifica ma anche l’impatto sulla società, la capacità di fare scuola e lavorare in team o la britannica SCOPE, che invita a ripensare anche agli effetti indesiderati e a valutare costi/benefici.Il denominatore comune è la logica di valutare ciò cui si dà valore.

Quello che mancava era però un’iniziativa comune, basata su principi condivisi, per allineare almeno a livello europeo le pratiche di valutazione in un’ottica di trasparenza e apertura, fungendo da leva anche in quelle situazioni ancora particolarmente legate a indicatori di carattere bibliometrico. La Commissione europea ha avuto il merito di avviare questo processo, e lo ha fatto in perfetta consonanza con le nuove regole di Horizon Europe, che compie un passo deciso in favore della Open Science inserendola - nella sezione Excellence-Methodology - fra i criteri di valutazione della proposta di progetto. In Horizon Europe l’idea centrale - lezione appresa dalla pandemia - è quella di una scienza che abbia impatto reale sulla società, e che sia in dialogo con gli attori sociali. In quest'ottica la Open Science non è mai una finalità in sé, ma uno strumento per rendere la scienza più solida (se rendo l’intero processo trasparente e condivido a ogni passo, risultano più difficili le frodi e ne guadagna l'integrità della ricerca) e rispondente ai bisogni della società.

La valutazione attuale, con il suo focus sulle pubblicazioni e sul prestigio della sede editoriale, non risulta più allineata con l’evoluzione delle pratiche di ricerca e con la nuova realtà di EOSC, la European Open Science Cloud, il cui pilastro è la condivisione e il riuso dei dati FAIR (Findable, Accessible, Interoperable, Reusable) in favore dell’innovazione e della crescita sociale.

La pandemia ha dimostrato chiaramente che la condivisione dei dati e dei risultati nel modo più aperto e più rapido possibile è l’unica via per accelerare la creazione di nuova conoscenza: non si può continuare a tenere i risultati della ricerca finanziata con fondi pubblici chiusa dietro abbonamenti da migliaia di euro, con tempi di pubblicazione che arrivano a due anni, spesso senza accesso ai dati o ai metodi e ai software usati per processarli, a scapito della riproducibilità. Inoltre, le sfide globali quali il cambiamento climatico o la stessa pandemia richiedono un approccio interdisciplinare che ha come presupposto proprio la condivisione dei dati.

Tutto questo è ben chiaro nel preambolo dell’iniziativa europea per la modifica dei criteri di valutazione, come si legge nel report Towards a reform of the research assessment system:

The research process is undergoing digital transformation, and is becoming less linear and more collaborative and open, and more multidisciplinary with a larger diversity of outputs. At the same time, the current research assessment system often uses inappropriate and narrow methods to assess the quality, performance and impact of research and researchers.[...] These major evolutions are not aligned with the metrics that often dominate assessment: the number of publications and citations, and the quantity of publications in journals with high Journal Impact Factor (JIF). The race for publications – the so-called publish-or-perish culture – comes at the expense of quality, integrity, and trust in research. Also, using the JIF as a proxy for quality of research is shown to be inappropriate.

È evidente come non sia facile scardinare un sistema in uso da anni e ben radicato - anche per la sua semplicità d’uso - nel sistema di finanziamento e di avanzamento della carriera. Ma l’esigenza è forte, ed era stata espressa anche in una serie di documenti ufficiali, a partire dalle Raccomandazioni del 2018 per finire con le Conclusioni [14126/21] del Consiglio Europeo sulla nuova governance della ERA - European Research Area (cfr. punto 3 dell’allegato A).

Per questo, la Commissione ha adottato un approccio di ascolto dei diversi stakeholder, prima con una consultazione durata tutto l’arco del 2021, e poi con il coinvolgimento di diversi attori nella stesura del testo dell’accordo, che dovrebbe essere finalizzato a giugno 2022 con successive iterazioni fra il gruppo di redattori e un gruppo di rappresentanti espressione di diverse realtà legate al mondo della ricerca.

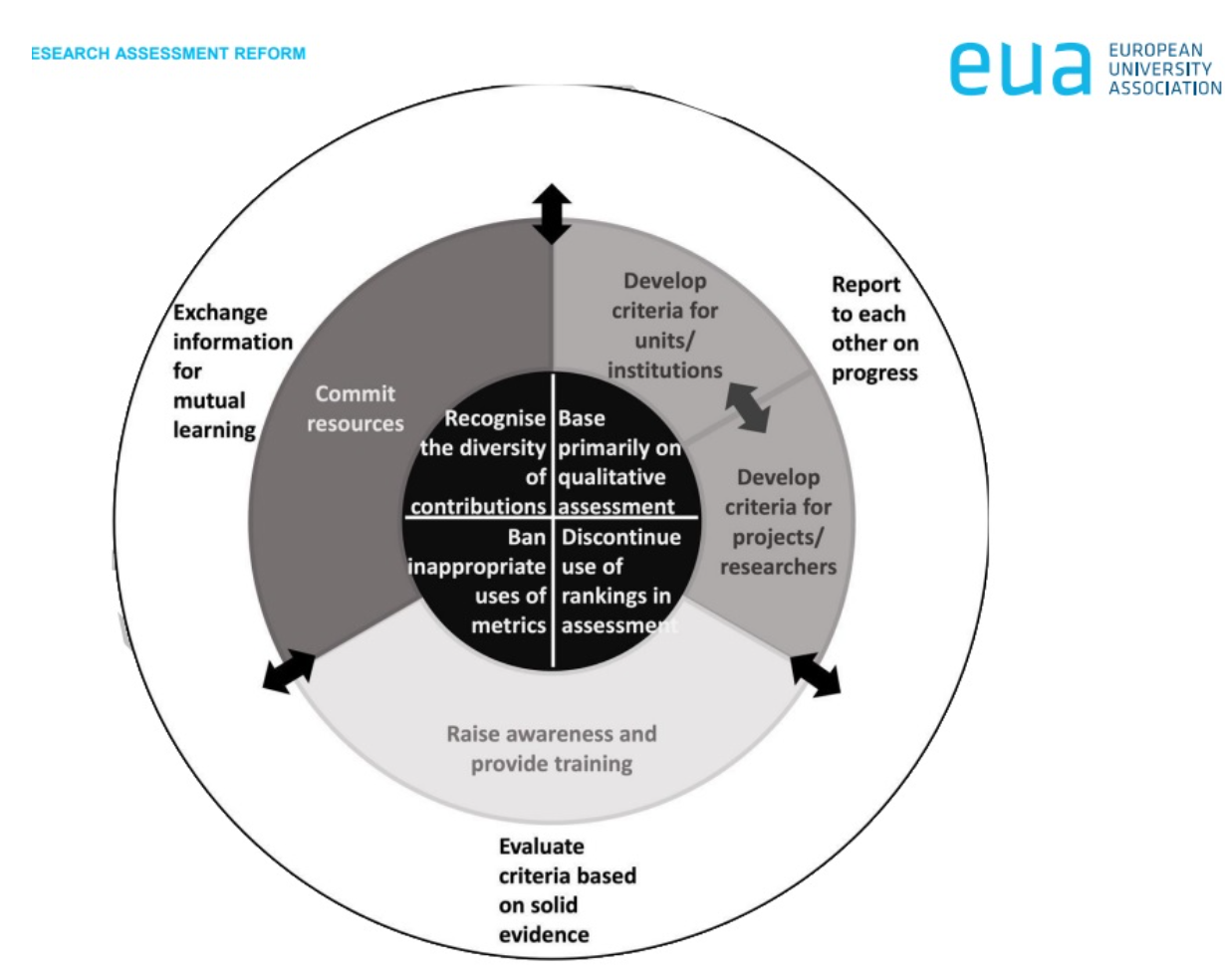

Fig. 1: Pastora Martinez Samper, Workshop I: Initiating the process of research assessment reform, EUA 22 Aprile 2022

La parola chiave è “flessibilità”, per venire incontro ai diversi utilizzi della valutazione e per rispettare le scelte di carriera di ricercatori impostate finora sui criteri tradizionali.

I nuovi criteri fanno perno sul concetto che i ricercatori siano valutati sui meriti intrinseci dei loro lavori, e non sul prestigio della sede editoriale. Per questo occorre:

- tenere conto di tutti i risultati della ricerca (dati, metodi, software…) e non solo della sintesi finale sotto forma di articolo

- riflettere la varietà delle attività connesse con la ricerca (la creazione di una scuola, la capacità di leadership, la relazione con il tessuto sociale)

- il rispetto della diversità e la capacità di inclusione

- il contributo alla mission dell’ente di ricerca

- l’approccio interdisciplinare e l’apporto all’innovazione e all’impatto sociale

- il riconoscimento delle pratiche di apertura, trasparenza e massima condivisione che accrescono la qualità del processo scientifico e la fiducia nella scienza

Non resta quindi che attendere la pubblicazione del testo finale dell’accordo e fare pressione su Ministero, ANVUR e sui nostri enti di ricerca perché lo firmino e si attivino con un piano di implementazione concreto e sostenibile.

Un’ultima notazione per rispondere all’obiezione iniziale: è vero che la modifica dei criteri di valutazione favorirà le pratiche di Open Science, ma questo non significa che anche con i criteri attuali non si possa già fare Open Science. Tutti gli strumenti che trovate nell'Arcobaleno della Open Science possono essere utilizzati anche ora, perché se le regole attuali vi dicono che dovete pubblicare sulla rivista più prestigiosa non vi vietano certo di condividere i dati o di pre-registrare il vostro esperimento o di condividere il software o la versione accettata del vostro articolo. Avete già a disposizione tutti gli strumenti per aprire ogni passo del vostro processo di ricerca, in ogni disciplina. Anzi, in Horizon Europe siete tenuti a farlo, inserendo le pratiche Open nella proposta di progetto, se no rischiate di non essere finanziati.

11 maggio 2022